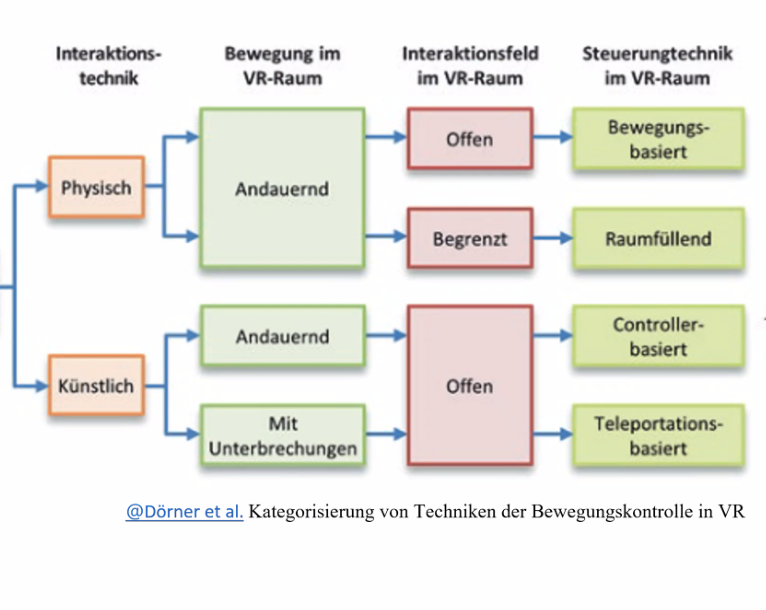

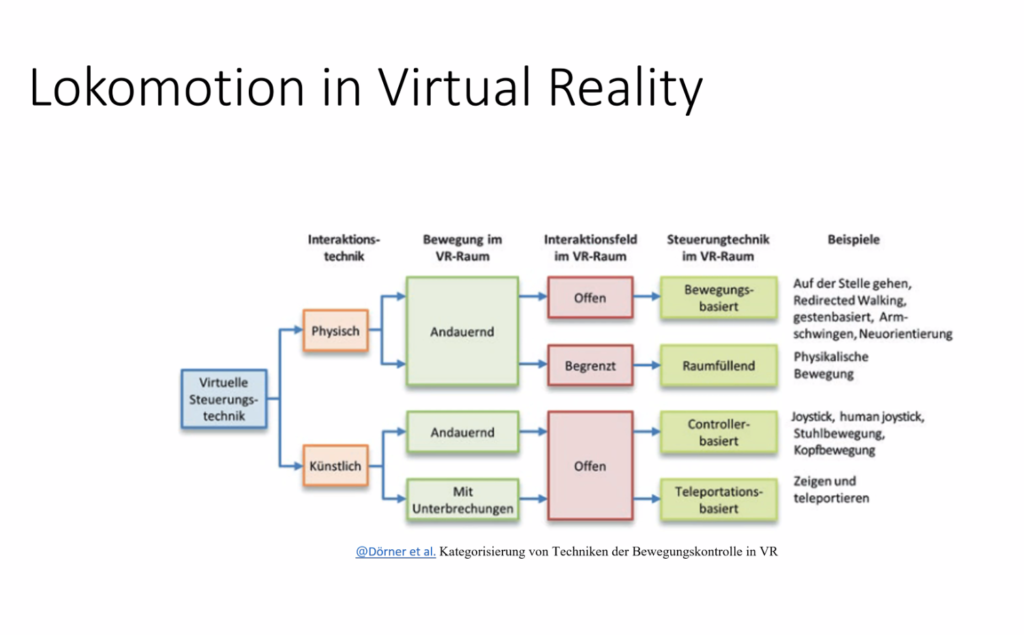

Das vierte Meeting zu XBPMMM startete mit einem Gastvortrag vom AURORA-Developer und Medieninformatiker Leonid Barsht zum Thema Lokomotion (Fortbewegung), Interaktion und User Interface in Virtual Reality.

Bei der anschließenden Diskussion wurde klar, dass wir in nächster Zukunft wohl einige VR-Anwendungen als Referenzen für Lokomotion und Interaktion testen werden – wir halten Euch auf dem Laufenden! Für XBPMMM ist eine Kombination verschiedener Lokomotions- und Interaktionsmöglichkeiten (evtl. je nach Level des Multiplayers) geplant.

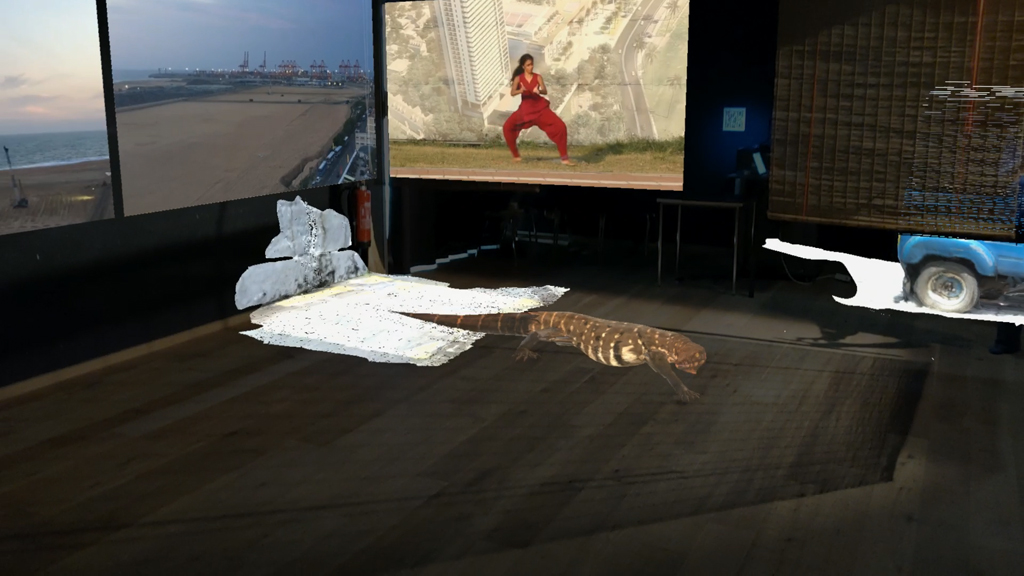

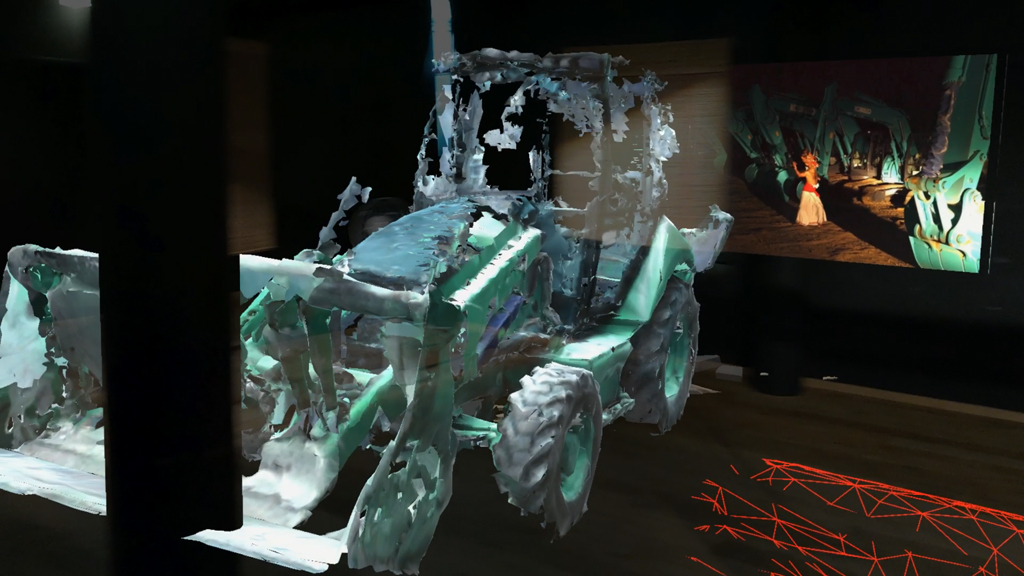

Und traraaaa: Bei diesem Meeting wurde das Unity-Projekt auf Basis der Vorarbeiten von Janne und Anton neu aufgesetzt und strukturiert. Das heißt, es kann jetzt – parallel zur Entwicklung des Storyboards/Ablaufs – allmählich mit dem Development losgehen!

Der Fokus von Storyboard und Development liegt erstmal auf dem Level 0, in dem man ankommt, und der dritten und damit letzten Szene – beides in Kombination mit den Softrobots und dem MQTT-Protokoll. Das Ziel ist dabei erstmal, den (browserbasierten) WebGL- und den VR-Multiplayer parallel zu denken und zu entwickeln.